آموزش استفاده از فایل robots.txt (video)

متن ویدیو فرمانروای گوگل شو!

ربات های گوگل را تحت اختیار خودت بگیر، بهشون دستور بده و بگو چکار کنند. می گویی چه جوری این کار را انجام بدهم. همراه من باش تا بهت بگویم که چه طوری ربات های گوگل را تحت اختیار خودت بگیری.

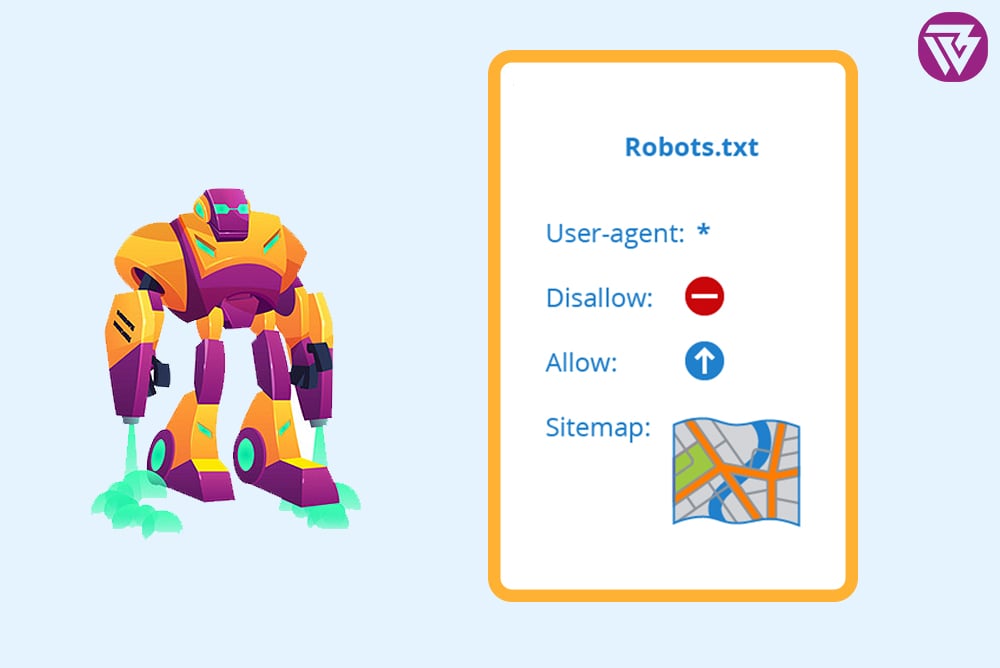

یک فایلی هست به نام robots.txt، می گذاری اش در روت هاستت و این جوری به آنها دستور می دهی. در این فایل اول با user agent مشخص می کنی که با کدام ربات داری صحبت می کنی و می خواهی به کی دستور بدهی. بعد با allow , disallow می گویی که به چی دسترسی داشته باشی و به چی دسترسی نداشته باشی. به چه دست بزن و به چه دست نزن.

حالا مگر برای گوگل اصلا اهمیت دارد که تو به ربات اش گفته ای که چکار کند. درست است شاید به یک سری صفحات که تو بگویی که نرود، هم برود و ببنید. اما آن تاثیر ایندکس شد را ندارد. ایندکس اش نمی کند! گوگل می گوید من باشد یا نباشد کار خودم را انجام می دهم. من چرا باید ازش استفاده کنم. چرا باید بگویم که این فایل وجود دارد و اتفاقات داخل آن را گفتم.

سه دلیل مهم دارد. اولین دلیل به گوگل می گویی صفحات عمومی و خصوصی من را نبین. یا این صفحات را ایندکس نکن.

دومین دلیل کرال بودجکت یا crawl budget ات را افزایش می دهی. یعنی چی؟ یعنی اینکه یک تایمی ربات های گوگل برای هر سایت در نظر می گیرند تا در داخلش خزش کنند. شما با دسترسی ندادن به صفحات غیر عمومی ات این تایم را بیشتر می کنی برای صفحاتی که باید ببیند. این کار باعث می شود که crawl budget شما افزایش پیدا کند.

سومین نکته: شما اگر کتابهای pdf یا mp3 ها یا محصولاتی را دارید داخل هاست تان هستند و گوگل می تواند آنها را ببیند. شما می آیید دسترسی را می بینید تا با یک جستجوی ساده، در گوگل پیدا نشوند تا بقیه نتوانند از آنها استفاده کنند. به همین سادگی، دسترسی ربات های گوگل را می بندی.

نکات خیلی مهمی را گفتم. امیدوارم که از آنها بتوانید استفاده کنید. و اختیار ربات های گوگل را به دست بگیرید. فقط فراموش نکن من بارها در آموزش سئو وبین سئو گفتم که site map سایت مپ ات را هم داخل robots.txt به گوگل معرفی کن. این باعث می شود که باز هم crawl budget تو افزایش پیدا کند. موفق و پیروز باشید.

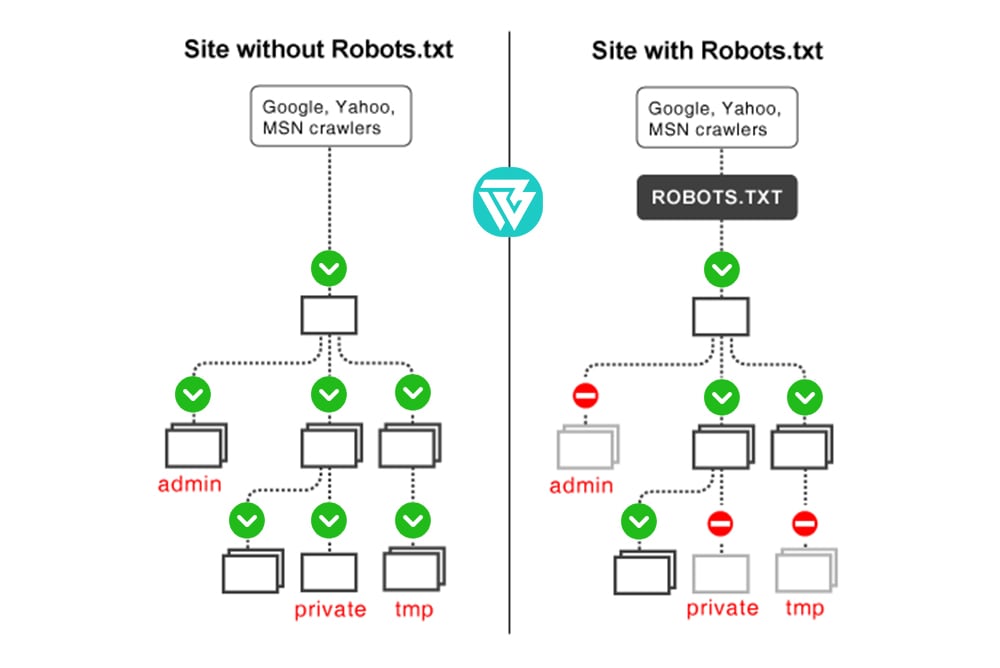

robots.txt فایل، یک فایل متنی می باشد که در Root Directory (روت دایرکتوری) یا مسیر اصلی هاست فضای وب سایت تان قرار دارد. با استفاده از این فایل شما در حقیقت به معرفی بخش های قابل دسترس و همچنین مشخص نمودن بخش هایی که نمی خواهید ربات های جستجوگر سطح وب یا همان Web Crawlers به آن ها دسترسی داسته باشند؛ می پردازید. در واقع این خزندگان سطح وب، با بررسی این فایل، اطلاعات سایت شما را به ثبت می رسانند.

robots.txtx کاربرد فایل از نگاهی دیگر محدود کردن دسترسی ها به محتوای سایت شما می باشد. اکثر ربات ها قبل از اینکه به بررسی و Index صفحات سایت بپردازند؛ قوانینی که در این فایل گذاشته اید را نگاه می اندازند و دقیقا به آنها پایبند خواهند بود و تنها به صفحاتی مراجعه می کنند که دسترسی اشان را باز گذاشته اید. اما فراموش نکنید که ربات هایی هم هستند که اصلا توجهی به این محدودیت ها ندارند و به همه بخش ها مراجعه می کنند.

جعبه مثال

برای مثال

ربات Email Harvesters و Spambots Malware و یا ربات هایی که وظیفه تامین امنیت را بر عهده دارند، جزء این موارد می باشند.

برای ایجاد فایل Robots.txt ابتدا شما باید به هاست دسترسی داشته باشید و این فایل را در ریشه اصلی آن کپی کنید. اگر به هر دلیلی شما به هاست دسترسی نداشته باشید میتوانید با قرار دادن تگ های متا در هدر صفحه دسترسی ربات های گوگل را به آن محدود نمایید. robots.txtx محل فایل در مسیر زیر قرار دارد که در تصویر نشان داده شده است.

چه فایل هایی نباید Index بشوند؟

همینطور که قبلا اشاره شد، می توانیم صفحاتی را که نمی خواهیم ایندکس بشوند را در فایل روبوت قرار بدهیم. این صفحات شامل موارد زیر می باشند:

- آن صفحاتی که محتوای تکراری دارند. Duplicate Content

- تگ ها و برچسب هایی که محتوای تکراری را در سایت ایجاد می کنند.

- فیلتربندی که در صفحات محصول فروشگاه تان قرار دارد مانند فیلترهای رنگ، قیمت و غیره

- آن دسته از صفحاتی که با جستجو در سایت به وجود می آیند.

- تمامی صفحات مربوط به ادمین و مدیریت سایت

- صفحات پروفایل کاربران

- صفحات چت روم

- برخی از فایل های مربوط به تنظیمات قالب.

چگونه از این فایل استفاده کنیم؟

robots.txtx کاربرد فایل بسیار ساده و انعطاف پذیر می باشد. کاربرد و فایده اصلی آن این است که به افراد متخصص در زمینه سئو این دسترسی را می دهد که به طور همزمان و بدون اینکه نیاز به تغییرات در سورس باشد به راحتی تغییرات لازم را اعمال نمایند و از ایندکس صفحه جلوگیری کنند. در ادامه به توضیح برخی از دستورات متداول در این فایل می پردازیم.

دستور User-agent

با استفاده از این دستور تنها یک ربات خاص را مدنظر قرار می دهیم. درصورتی که ورودی آن را علامت “*” بگذاریم، تمامی ربات های خزنده شامل این دستور می شوند و همچنین در ابتدای فایل این کد را می نویسیم.

*:User-agent

User-agent : Googlebot

تنظیمات فقط بر روی یک ربات خاص اعمال می شود.

دستور Disallow

این دستور به مانند یک کلید عمل می کند برای باز کردن پوشه ها. با این کد آدرس صفحه ای را که می خواهید ربات ها به آن دسترسی نداشته باشند، پنهان می کنید. به عنوان مثال می توانید دسترسی به پوشه تصاویر و ویدیو ها را و یا صفحه ادمین سایت را با این کد ببندید.

*:User-agent

Disallow : /photos

پوشه تصاویر قفل می شوند.

دستور Allow

ربات Googlebot وظیفه ایندکس کردن را بر عهده دارد. با استفاده از کد allow اجازه مشاهده یک فایل در فولدری که قبلا Disallowed شده را می دهید.

*:User-agent

Disallow : /photos

Allow : /photos/ img.png

با این دستور شما به یک تصویر خاص در پوشه ای که قفل شده است دسترسی پیدا می کنید.

اضافه کردن sitemap به فایل

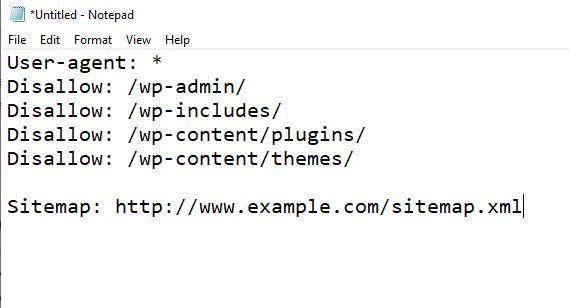

برای اینکه در وردپرس robots.txt فایل مسیر نقشه سایت را نشان بدهیم باید مانند تصویر زیر کد Sitemap: http://www.example.com/sitemap.xml را به انتهای فایل اضافه کنیم.

علی

سلام. وقتتون بخیر باشه. در سرچ کنسول، قسمت sitemaps در status کلمه couldn’t fetch را نوشته و وقتی به فایل robots سایت نگاه کردم دیدم

User-agent : Googlebot در دستورات نیست و اضافه کردم. بنظرتون مشکل از این موضوع می تونه باشه؟ چون URL سایت مپ سایتمم نمیاره و ۴۰۴ میده

دستوراتی که در فایل robots از قبل بود :

User-agent: MJ12bot

Disallow: /

User-agent: AhrefsBot

Disallow: /

User-agent: msnbot

Disallow: /

User-agent: amazonbot

Disallow: /

User-agent: bingbot

Disallow: /

User-agent: YandexBot

Disallow: /

محمد نصیری

درود وقت بخیر

علی عزیز اصلا نیازی به اضافه کردن گوگل نیست زمانی باید اضافه کنید که قرار دسترسی به بخشی از سایت رو ببندید اما وقتی آدرس سایت مپ به طور عادی ۴۰۴ میشه پس آدرس مسئله داره و باید اول لود شدن سایت مپ رو برطرف کنید.

علی اصغر

سلام ، وقت بخیر

ببخشید یه سوال داشتم اگه راهنمایی کنید ممنون میشم ازتون .

تو موتور جستجوی بینگ سایت من بجای اینکه خود صفحه اصلی سایت ایندکس بشه آدرس ورود به کنترل پنل ایندکس شده به این صورت sitename.ir:2082

تو وبمستر بینگ اجازه بلاک کردن لینک و نمیده و بخوام تو فایل robot.txt این صفحه را وارد کنم باید به چه صورت تعریف کنم ؟

محمد نصیری

درود وفت بخیر

باید در فایل دقیقا مثل ربات های دیگه آدرس رو disallow کنید.

علیمرادی

سلام

ممنون از راهنمایی تون

علیمرادی

سلام و خسته نباشید

حدود ۴ سال است سایتم در گوگل، بینگ و …ایندکس است و معمولا در صفحه اول سرچ هست، اما پس از نصب افزونه المنتور و تغییر صفحه اصلی سایتم(که قصدم بهبود و زیبا کردن صفحه اصلی بود) دیگه صفحه اصلی سایت در سرچ گوگل مشاهده نمی گردد و در مروگر بینگ نیز سایتم به کلی حذف شده و قابل شناسایی نیست.

سوال: آیا مربوط به خطای زیر است؟

User-agent: *

Disallow:

محمد نصیری

درود وقت بخیر

سایت شما خطاهای زیادی داره و باید بیشتر بررسی شود برای ثبت تحلیل سئو سایت کلیک کنید.تحلیل سئو سایت

مبتدی

با سلام و خسته نباشید .. بنده مبتدی هستم گاهی وقتا مطلب جدیدی که ارسال میکنم بعد چند روز ایندکس میشه اما بعضی هاشون حذف میشن و بجاش صفحات سایت بجای اون مطلب قرار میگیرین یعنی اگه اون مطلب در صفحه ۱۲ باشه صفحه ۱۲ ایندکس میشه بجای مطلبم حالا بعضی وقتا درست میشه بعضی وقتا کلا پست رو حذف میکنم دوباره ارسال میکنم درست میشه الان من چطور باید صفحه سایتم رو نوایندکس کنم یعنی کدش چیه تا در Robots.txt قرار بدم ایا این کار یعنی نو ایندکس صفحه بندی مشکلی برای سایت پیش میاره و پنالتی میشم از نظر گوگل ؟

محمد نصیری

درود وقت بخیر

مسئله شما ارتباطی به فایل robots نداره و باید اگر از وردپرس استفاده می کنید در تنظیمات افزونه Yoast جلوی ایندکس شدن این صفحات رو بگیرید.